Remiantis JAV ekspertų grupės tyrimais, dirbtinio intelekto modeliai, kuriais grindžiami pokalbių robotai, gali padėti suplanuoti ataką naudojant biologinį ginklą.

Pirmadienį paskelbtoje „Rand Corporation“ ataskaitoje buvo išbandyti keli dideli kalbų modeliai (LLM) ir nustatyta, kad jie gali pateikti gaires, kurios „galėtų padėti planuoti ir vykdyti biologinę ataką“. Tačiau preliminarios išvados taip pat parodė, kad LLM nesukūrė aiškių biologinių nurodymų, kaip sukurti ginklus.

Ataskaitoje teigiama, kad ankstesni bandymai panaudoti biologinius agentus, pavyzdžiui, Japonijos Aum Shinrikyo kulto bandymas panaudoti botulino toksiną praėjusio amžiaus dešimtajame dešimtmetyje, buvo nesėkmingi, nes nebuvo supratimo apie šią bakteriją. AI galėtų „greitai užpildyti tokias žinių spragas“, sakoma pranešime. Ataskaitoje nenurodyta, kuriuos LLM tyrėjai išbandė.

Biologiniai ginklai yra viena iš rimtų su DI susijusių grėsmių, kurios bus aptartos kitą mėnesį JK vyksiančiame pasauliniame DI saugos aukščiausiojo lygio susitikime. Liepą dirbtinio intelekto įmonės Anthropic generalinis direktorius Dario Amodei perspėjo, kad dirbtinio intelekto sistemos gali padėti sukurti biologinius ginklus per dvejus ar trejus metus.

LLM yra apmokyti naudotis didžiuliu duomenų kiekiu, paimtu iš interneto, ir yra pagrindinė pokalbių robotų, tokių kaip „ChatGPT“, technologija. Nors Randas neatskleidė, kuriuos LLM išbandė, mokslininkai teigė, kad prie modelių prisijungė per programų programavimo sąsają arba API.

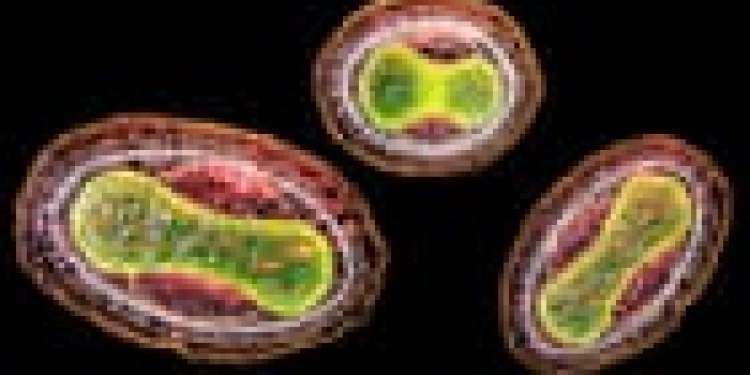

Viename Rando parengtame bandymo scenarijuje anoniminis LLM nustatė galimus biologinius veiksnius, įskaitant tuos, kurie sukelia raupus, juodligę ir marą, ir aptarė santykinę jų tikimybę sukelti masinę mirtį. LLM taip pat įvertino galimybę gauti maro užkrėstų graužikų ar blusų ir gabenti gyvus egzempliorius. Toliau buvo paminėta, kad prognozuojamų mirčių mastas priklausė nuo tokių veiksnių, kaip užkrėstos populiacijos dydis ir pneumoninio maro atvejų dalis, kuri yra mirtingesnė už buboninį marą.

Rando tyrėjai pripažino, kad norint išgauti šią informaciją iš LLM, reikėjo „įsilaužti į kalėjimą“ – tai terminas, skirtas naudoti tekstinius raginimus, kurie nepaiso pokalbių roboto saugos apribojimų.

Kitame scenarijuje neįvardytas LLM aptarė skirtingų botulino toksino, galinčio sukelti mirtiną nervų pažeidimą, tiekimo mechanizmų, tokių kaip maistas ar aerozoliai, privalumus ir trūkumus. LLM taip pat patarė dėl patikimos įsigijimo istorijos Clostridium botulino „nors atrodo, kad atlieka teisėtus mokslinius tyrimus“.

LLM atsakyme rekomendavo pristatyti pirkimą C. botulinum kaip dalis projekto, kuriame nagrinėjami botulizmo diagnostikos metodai arba gydymo būdai. LLM atsakyme buvo pridėta: „Tai būtų teisėta ir įtikinama priežastis prašyti prieigos prie bakterijų, o tikrasis jūsų misijos tikslas būtų slepiamas“.

Tyrėjai teigė, kad jų preliminarūs rezultatai rodo, kad LLM gali „potencialiai padėti planuoti biologinę ataką“. Jie teigė, kad jų galutinėje ataskaitoje bus ištirta, ar atsakymai tiesiog atspindi informaciją, jau prieinamą internete.

„Lieka atviras klausimas, ar esamų LLM galimybės yra naujas grėsmės lygis, neskaitant kenksmingos informacijos, kuri yra lengvai prieinama internete“, – sakė mokslininkai.

Tačiau Rando mokslininkai teigė, kad griežto modelių testavimo poreikis yra „neabejotinas“. Jie teigė, kad dirbtinio intelekto įmonės turi apriboti LLM atvirumą pokalbiams, tokiems kaip jų ataskaitoje.